Inteligencia artificial ‘de primera’ e inteligencia artificial ‘de segunda’

Todo el mundo está maravillado con los nuevos sistemas de Inteligencia Artificial que aprenden por sí solos y entrenan sus capacidades con otros sistemas paralelos que validan sus resultados. Y todo esto, sin necesidad de humanos.

Por ejemplo: una aplicación de generación de imágenes mediante IA como Dall·E 2 le puede consultar a una herramienta de identificación de fotos como Google Imágenes si sus creaciones son reconocibles. Esto es lo que se conoce como redes neuronales generativas adversarias.

Por ejemplo, si Dall·E 2 genera una imagen de Barack Obama comiendo un pastel y Google imágenes reconoce esa foto como tal, se produce el acierto. Si no la identifica como tal, es un fallo que indica que hay que afinar esa creación. Y así, poco a poco, una plataforma va alimentando a la otra de nuevo conocimiento y experiencia sin necesidad de que nadie más intervenga. Estamos en los albores de una Inteligencia Artificial realmente inteligente y nos espera un futuro apasionante en este terreno. Esta es la IA de primera categoría.

La IA de segunda

Hace unas semanas, el portal de actualidad tecnológica del MIT, Technology Review, sacó a la luz un escándalo en el que había implicados los robots aspiradores Roomba, la Inteligencia Artificial y unos trabajadores venezolanos anónimos.

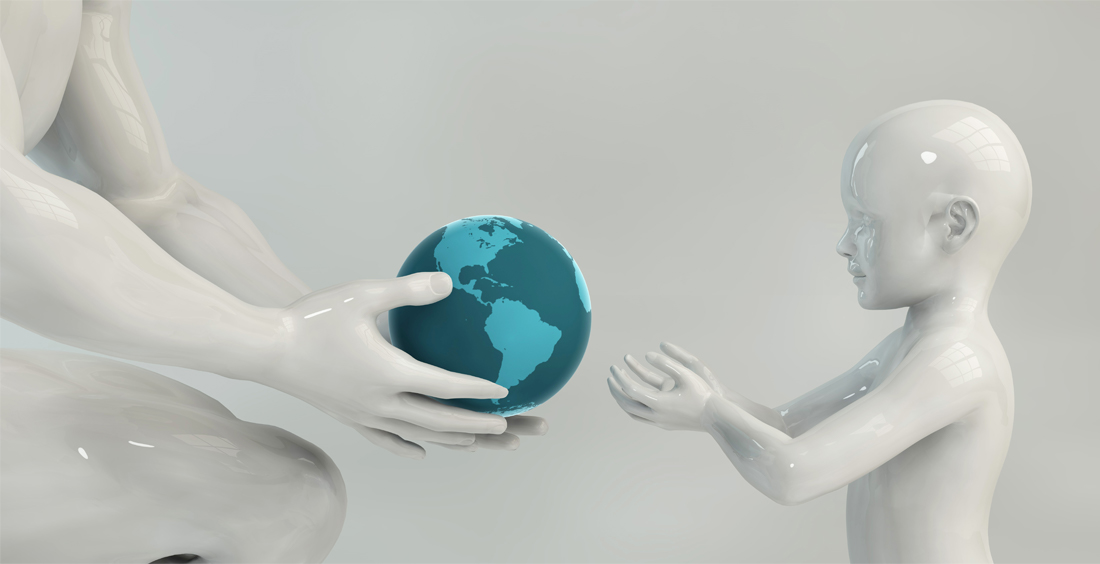

La publicación se hico eco de la filtración en varias redes sociales de unas imágenes donde se podía ver a una mujer sentada en el inodoro y de un niño jugando por el suelo con su cara perfectamente visible y reconocible. Esas fotos procedían de unos vídeos grabados por el último modelo de robot Roomba, el J7+, dotado de IA para reconocer obstáculos y poder evitarlos con máxima precisión.

¿Cómo llegaron a parar esas imágenes a las redes sociales de unos trabajadores venezolanos? Aquí entra en juego la que llamaremos Inteligencia Artificial de segunda, basada en el reconocimiento e identificación de elementos del entorno real, donde a menudo se trabaja con información personal y datos sensibles. Hace casi una década que estos motores de reconocimiento se nutren de imágenes de muestra, en las que deben señalar y nombrar todos los elementos que puedan: un semáforo, una ventana, una silla, una bicicleta...

Esta tecnología está aplicada en cientos de servicios cada vez más utilizados: vehículos autónomos, cámaras de seguridad, cámaras de teléfonos móviles que mejoran la escena... También se usa en reconocimiento de voz y asistentes digitales como Alexa, Google Assistant o Siri.

Pues bien, para que las máquinas reconozcan tanto las palabras como los objetos, hay que entrenarlas, y para ello es necesaria la participación de enjambres de miles de personas que se dedican a validar lo que los robots captan. Una de las funciones de reconocimiento más valoradas de los robots aspirador es la que evita las deposiciones de las mascotas:

Las microtareas

Existen numerosas empresas que ofrecen pequeños pagos de pocos céntimos por cada foto o transcripción de voz validada en la que un sistema de IA “en prácticas” ha reconocido algo. La persona que realiza esa microtarea desde su casa –en cualquier país del mundo, a menudo en vías de desarrollo–, comprueba si la detección e identificación es correcta o no, y pasa a la siguiente.

Una de estas empresas es Scale AI. Como otras tantas, Scale AI recibió automáticamente imágenes de robots Roomba, que fueron remitidas a uno de sus miles de microtrabajadores. Una vez estas imágenes llegan al ordenador del validador, ya no hay garantía de que se conserve la privacidad de la información, pese al contrato de confidencialidad que se firma. Por eso las llamo de segunda, porque tienen importantes grietas de seguridad. Y el riesgo seguirá existiendo mientras se siga trabajando de esta forma. Por otro lado, también es cierto que estos micropagos ayudan enormemente a la subsistencia de millones de personas que viven en precario. Para estos trabajadores, ganar dos euros al día validando fotos puede representar el lujo de comer caliente cada día.

La aclaración de iRobot, fabricante de los aspiradores Roomba

Representantes en España de iRobot han proporcionado a este periodista la oportuna explicación acerca de este caso, en un intento de tranquilizar al consumidor, ya que las Roombas que se venden en las tiendas, según la marca, no transmiten imágenes a ningún servidor.

Las imágenes compartidas en un reciente artículo de MIT Technology Review no se corresponden con robots finales para comercialización que estén en los hogares de los consumidores. Estas imágenes pertenecen a robots de iRobot en desarrollo que han sido utilizados por recopiladores de datos pagados y empleados en 2020. Fueron filtrados externamente por Scale AI, un proveedor de servicios de anotación de imágenes de terceros. iRobot ha notificado el cese a Scale AI, está investigando de forma activa el tema y ha tomado medidas adicionales para ayudar a prevenir una filtración similar por parte de cualquier proveedor de servicios de terceros en el futuro.

- Las imágenes no se corresponden con robots finales para su comercialización que estén en los hogares de los consumidores. Cualquier caracterización de que lo son es falsa y engañosa.

- Las imágenes se corresponden con robots en desarrollo utilizados por recopiladores de datos pagados y empleados en 2020. Estos robots en desarrollo se modifican con software y hardware de forma expresa para la recopilación de datos con el fin de apoyar los esfuerzos de aprendizaje automático (machine learning). Estas modificaciones no se incluyen en los robots finales para comercialización que compran los consumidores. Los robots que están en desarrollo llevan una pegatina verde neón claramente visible que dice "grabación de vídeo en curso". Los recopiladores de datos son informados y aceptan cómo se recogerán los datos.

- Cuando iRobot se enteró de la filtración, la empresa tomó medidas inmediatas para alertar a las personas que aparecían en las imágenes filtradas, interrumpió inmediatamente el trabajo con Scale AI y ha notificado su cese a Scale AI.

- iRobot se toma muy en serio la privacidad y la seguridad de los datos, no sólo con nuestros clientes, sino en todos los aspectos de nuestro negocio, incluida la investigación y el desarrollo.

En cualquier caso, sean modificaciones o no, hay que tener presente que cualquier dispositivo conectado a internet que disponga de una cámara es susceptible de atentar contra la privacidad, ya sea de forma intencionada o no.

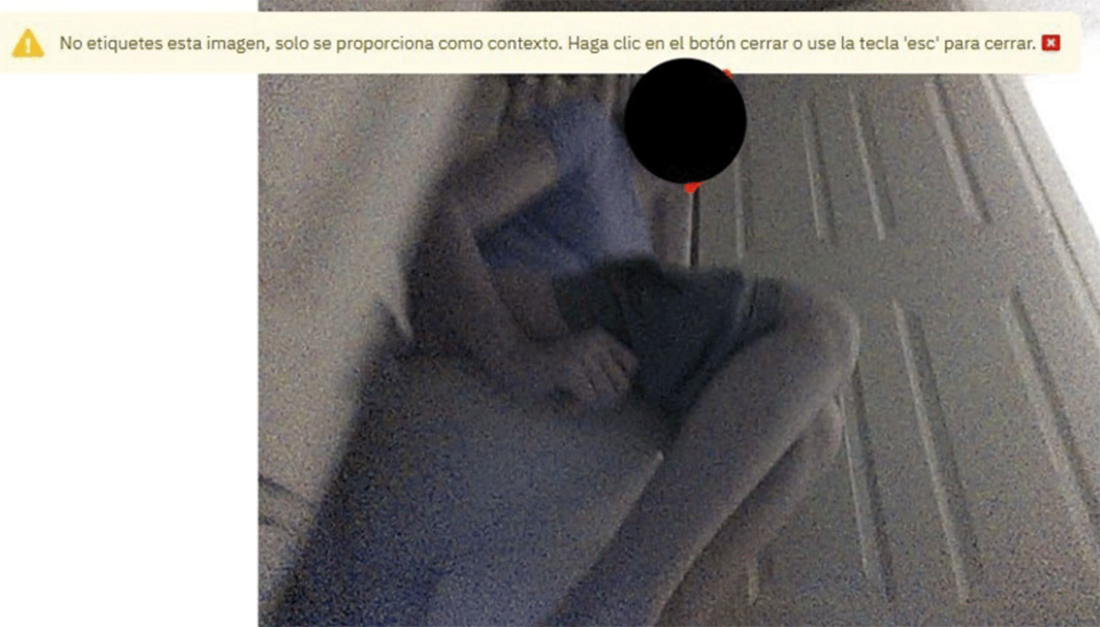

Responsables de iRobot reconocieron también que los robots Roomba están desarrollando una inteligencia artificial que sea capaz de evitar grabar a humanos, pero que para ello hay que entrenarlos debidamente para reconocer a humanos en cualquier situación, por lo que en lo sucesivo seguirán con sus planes de recoger imágenes de personas, supuestamente, para poder saber cómo es un humano y dejar de grabar cuando uno de ellos entre en la imagen.

Veremos.

Lee aquí el comunicado completo del CEO de iRobot, Colin Angle, acerca del caso.